| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- collections

- C언어

- yarn

- python

- tensorflow

- effective python

- 그래프이론

- HelloWorld

- scrapy

- 파이썬

- 하둡2

- 알고리즘

- 코딩더매트릭스

- NumPy

- 주식분석

- GRU

- LSTM

- recursion

- C

- graph

- 텐서플로

- 하이브

- codingthematrix

- 딥러닝

- Java

- RNN

- 선형대수

- Sort

- hive

- hadoop2

- Today

- Total

목록DeepLearning/개념 (12)

EXCELSIOR

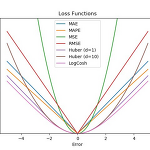

Loss functions for Regression

Loss functions for Regression

Loss functions for Regression 1. Loss functions for regression Mean Absolute Error (MAE) Mean Absolute Percentage Error (MAPE) Mean Squared Error (MSE) Root Mean Squared Error (RMSE) Huber Loss Log-Cosh Loss 2. Mean Absolute Error (MAE, L1 Loss) MAE는 가장 단순한 형태의 loss function이라고 할 수 있음 각각의 실제값($y_i$)과 예측값($\hat{y}_i$) 간의 차이의 절대값을 구한 후 평균을 구한것을 MAE라 함 수식은 다음과 같음 $$ \text{MAE} = \frac{1}{n} \sum_{i..

08. 오토인코더 (AutoEncoder)

08. 오토인코더 (AutoEncoder)

이번 포스팅은 핸즈온 머신러닝 교재를 가지고 공부한 것을 정리한 포스팅입니다. 08. 오토인코더 - Autoencoder 저번 포스팅 07. 순환 신경망, RNN에서는 자연어, 음성신호, 주식과 같은 연속적인 데이터에 적합한 모델인 RNN, LSTM, GRU에 대해 알아보았다. 이번 포스팅에서는 딥러닝에서의 비지도 학습(unsupervised learning)이라고 할 수 있는 오코인코더(autoencoder)에 대해 알아보도록 하자. 1. 오토인코더 란?오토인코더(Autoencoder)는 아래의 그림과 같이 단순히 입력을 출력으로 복사하는 신경망이다. 어떻게 보면 간단한 신경망처럼 보이지만 네트워크에 여러가지 방법으로 제약을 줌으로써 어려운 신경망으로 만든다. 예를들어 아래 그림처럼 hidden lay..

07-3. 순환 신경망 LSTM, GRU - (3)

07-3. 순환 신경망 LSTM, GRU - (3)

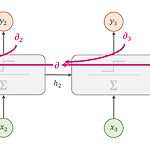

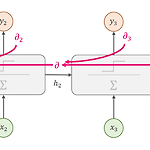

이번 포스팅은 핸즈온 머신러닝 교재, cs231n 강의를 가지고 공부한 것을 정리한 포스팅입니다. RNN에 대해 좀더 간략하게 알고 싶으신 분들은 아래의 링크를 참고하면 됩니다. 텐서플로 실습 위주 : [러닝 텐서플로]Chap06 - 텍스트2: word2vec, Bidirectional RNN, GRU, 임베딩 시각화LSTM & GRU의 간략한 설명 : RNN - LSTM(Long Short Term Memory networks) 07-3. 순환 신경망 LSTM, GRU - (3) 저번 포스팅인 07-2. 순환 신경망(RNN) - (2)에서는 RNN을 학습시키는 방법인 BPTT와 텐서플로를 이용해 MNIST 분류기와 시계열 데이터를 예측하는 RNN 모델을 구현해 보았다. 그리고 심층 RNN을 구현하는 방..

07-2. 순환 신경망 (RNN, Recurrent Neural Network) - (2)

07-2. 순환 신경망 (RNN, Recurrent Neural Network) - (2)

07-2. 순환 신경망 (RNN, Recurrent Neural Network) - (2) 저번 포스팅인 07-1. 순환 신경망 - (1)에서는 시계열 데이터에 적합한 모델인 RNN의 구조와 텐서플로(TensorFlow)의 BasicRNNCell과 static_rnn(), dynamic_rnn()을 이용해 RNN을 구현하는 방법에 대해 알아보았다. 이번 포스팅에서는 RNN을 학습시키는 방법과 심층 RNN에 대해 알아보도록 하자. 1. RNN 학습시키기 1.1 BPTT (BackPropagation Through Time)RNN은 기존 신경망의 역전파(backprop)와는 달리 타임 스텝별로 네트워크를 펼친 다음, 역전파 알고리즘을 사용하는데 이를 BPTT(BackPropagation Through Tim..

07-1.순환 신경망(RNN, Recurrent Neural Network) - (1)

07-1.순환 신경망(RNN, Recurrent Neural Network) - (1)

이번 포스팅은 핸즈온 머신러닝 교재, cs231n 강의를 가지고 공부한 것을 정리한 포스팅입니다. RNN에 대해 좀더 간략하게 알고 싶으신 분들은 아래의 링크를 참고하면 됩니다.텐서플로 실습 위주 : [러닝 텐서플로]Chap05 - 텍스트 1: 텍스트와 시퀀스 처리 및 텐서보드 시각화 07-1. 순환 신경망 (RNN, Recurrent Neural Network) - (1) 저번 포스팅인 06. 합성곱 신경망 - CNN에서는 이미지 데이터에 적합한 모델인 CNN에 대해 알아보았다. 이번 포스팅에서는 아래의 그림과 같이 자연어(NL, Natural Language)나 음성신호, 주식과 같은 연속적인(sequential) 시계열(time series) 데이터에 적합한 모델인 RNN(Recurrent Neur..

06. 합성곱 신경망 - Convolutional Neural Networks

06. 합성곱 신경망 - Convolutional Neural Networks

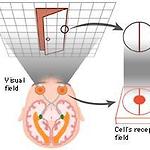

이번 포스팅은 핸즈온 머신러닝 교재, cs231n 강의를 가지고 공부한 것을 정리한 포스팅입니다. CNN에 대해 좀 더 간략하게 알고 싶으신 분들은 아래의 링크를 참고하면 됩니다.간략한 설명 : 합성곱신경망(CNN, Convolutional Neural Network)텐서플로 실습 위주 : [러닝 텐서플로]Chap04 - 합성곱 신경망 CNN 06. 합성곱 신경망 - Convolutional Neural Networks1. CNN의 기원David H. Hubel과 Torsten Wiesel은 1958년과 1959년에 시각 피질의 구조에 대한 결정적인 통찰을 제공한 고양이 실험을 수행했다. 이들은 시각 피질 안의 많은 뉴런이 작은 local receptive field(국부 수용영역)을 가진다는 것을 보였..

05-2. 심층 신경망 학습 - 배치 정규화, 그래디언트 클리핑

05-2. 심층 신경망 학습 - 배치 정규화, 그래디언트 클리핑

05-2. 심층 신경망 학습 - 배치 정규화, 그래디언트 클리핑저번 포스팅 05-1. 심층 신경망 학습에서는 DNN 학습에 있어서 적절한 활성화 함수 및 가중치 초기화 방법에 대해 알아보았다. 이번 포스팅에서는 그래디언트 소실(vanishing gradient)과 폭주(exploding) 문제를 해결하는 방법인 배치 정규화(BN, Batch Normalization)와 그래디언트 클리핑(Gradient Clipping), 그리고 학습 속도를 높일 수 있는 최적화(Optimization) 방법에 대해 알아보도록 하자. 1. 배치 정규화(BN, Batch Normalization)05-1. 심층 신경망 학습에서는 활성화 함수로는 ReLU를 사용하고 He 초기화를 통해 학습 초기 단계에서의 그래디언트 소실/폭..

05-1. 심층 신경망 학습 - 활성화 함수, 가중치 초기화

05-1. 심층 신경망 학습 - 활성화 함수, 가중치 초기화

5-1. 심층 신경망 학습 - 활성화 함수, 가중치 초기화 저번 포스팅 04. 인공신경망에서 예제로 살펴본 신경망은 hidden layer가 2개인 얕은 DNN에 대해 다루었다. 하지만, 모델이 복잡해질수록 hidden layer의 개수가 많은 신경망 모델을 학습시켜야 한다. 이러한 깊은 DNN 모델을 학습시키는데에는 다음과 같은 문제가 발생할 확률이 높다.그래디언트 소실(vanishing gradient) 또는 폭주(exploding)가 발생할 수 있다.모델이 복잡하고 커질수록 학습시간이 매우 느려진다.모델이 복잡할수록 오버피팅(overfitting)될 위험이 크다.이번 포스팅에서는 이러한 문제들에 대해 알아보고 해결할 수 있는 활성화 함수와 가중치 초기화 방법에 대해 알아보도록 하자. 1. 그래디언트..