| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- codingthematrix

- tensorflow

- 하이브

- 선형대수

- Sort

- collections

- RNN

- NumPy

- C언어

- yarn

- LSTM

- C

- 텐서플로

- 하둡2

- python

- GRU

- 파이썬

- 알고리즘

- 딥러닝

- 그래프이론

- 주식분석

- graph

- scrapy

- hive

- recursion

- 코딩더매트릭스

- HelloWorld

- hadoop2

- effective python

- Java

- Today

- Total

목록RNN (5)

EXCELSIOR

07-2. 순환 신경망 (RNN, Recurrent Neural Network) - (2)

07-2. 순환 신경망 (RNN, Recurrent Neural Network) - (2)

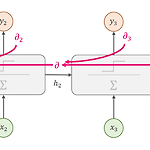

07-2. 순환 신경망 (RNN, Recurrent Neural Network) - (2) 저번 포스팅인 07-1. 순환 신경망 - (1)에서는 시계열 데이터에 적합한 모델인 RNN의 구조와 텐서플로(TensorFlow)의 BasicRNNCell과 static_rnn(), dynamic_rnn()을 이용해 RNN을 구현하는 방법에 대해 알아보았다. 이번 포스팅에서는 RNN을 학습시키는 방법과 심층 RNN에 대해 알아보도록 하자. 1. RNN 학습시키기 1.1 BPTT (BackPropagation Through Time)RNN은 기존 신경망의 역전파(backprop)와는 달리 타임 스텝별로 네트워크를 펼친 다음, 역전파 알고리즘을 사용하는데 이를 BPTT(BackPropagation Through Tim..

07-1.순환 신경망(RNN, Recurrent Neural Network) - (1)

07-1.순환 신경망(RNN, Recurrent Neural Network) - (1)

이번 포스팅은 핸즈온 머신러닝 교재, cs231n 강의를 가지고 공부한 것을 정리한 포스팅입니다. RNN에 대해 좀더 간략하게 알고 싶으신 분들은 아래의 링크를 참고하면 됩니다.텐서플로 실습 위주 : [러닝 텐서플로]Chap05 - 텍스트 1: 텍스트와 시퀀스 처리 및 텐서보드 시각화 07-1. 순환 신경망 (RNN, Recurrent Neural Network) - (1) 저번 포스팅인 06. 합성곱 신경망 - CNN에서는 이미지 데이터에 적합한 모델인 CNN에 대해 알아보았다. 이번 포스팅에서는 아래의 그림과 같이 자연어(NL, Natural Language)나 음성신호, 주식과 같은 연속적인(sequential) 시계열(time series) 데이터에 적합한 모델인 RNN(Recurrent Neur..

Chap07.2 - 텐서플로 추상화와 간소화, TFLearnTFLearn은 Chap07.1 Estimator에서 살펴본 tf.estimator와 마찬가지로 텐서플로의 추상화 라이브러리이다. 이번에는 TFLearn에 대해 알아보도록 하자. 7.3 TFLearn7.3.1 설치TFLearn은 텐서플로에 포함되어 있지 않기 때문에 별도의 설치가 필요하다. Terminal(또는 cmd창)에 pip 명령을 이용해 설치할 수 있다. pip install tflearn 7.3.2 CNNTFLearn은 Chap07.1 - tf.estimator와 유사하지만, TFLearn을 사용하면 조금 더 깔끔하게 모델을 만들 수 있다. TFLearn.org에서는 TFLearn을 다음과 같이 소개하고 있다.Easy-to-use and..

[러닝 텐서플로]Chap05 - 텍스트 1: 텍스트와 시퀀스 처리 및 텐서보드 시각화

[러닝 텐서플로]Chap05 - 텍스트 1: 텍스트와 시퀀스 처리 및 텐서보드 시각화

Chap05 - 텍스트 1: 텍스트와 시퀀스 처리 및 텐서보드 시각화텐서플로에서 시퀀스(sequence) 데이터인 텍스트를 어떻게 다루는지 알아보고, RNN 구현방법 및 텐서보드를 이용한 시각화에 대해 알아본다. 그 다음 단어 임베딩 학습 및 LSTM을 구현해본다. 5.1 시퀀스 데이터의 중요성Chap04-합성곱 신경망 CNN에서 이미지의 공간(spatial) 구조를 이용하여 CNN을 구현하였고, 이러한 구조를 활용하는 것이 중요하다는 것을 알아 보았다. 이번에 알아볼 순차형 데이터 구조인 시퀀스(sequence) 데이터 또한 중요하고 유용한 구조이다. 시퀀스 데이터란 각각의 데이터가 순서가 있는 데이터를 말하며, 다양한 분야에서 찾을 수가 있다. 예를 들어, 음성신호, 텍스트, 주가 데이터 등이 있다...

RNN - LSTM(Long Short Term Memory networks)

RNN - LSTM(Long Short Term Memory networks)

이번 LSTM은 Chris송호연님의 블로그와 aikorea.org를 많이(실은 거의...) 참조하였으며, 이미지 출처는 원 저작자인 Colah.github.io 입니다. 문제가 될경우 삭제 하겠습니다..ㅜㅜ 1. LSTM 배경 - 장기 의존성(Long-Term Dependency) 문제점 RNN의 장점은 이전의 정보를 공유하여 활용할 수 있다는 것이다. 하지만, 시점간의 간격(Gap)이 크지 않을 경우에 가능하며 이러한 문제의 원인은 Vanishing Gradient에서 알 수 있듯이 BPTT에서 Chain Rule에 의해 [-1, 1]사이의 값들이 계속 곱해지다보니 앞쪽으로 갈 수록 그 값이 작아져, 결국에는 소멸해버려 Parameter들의 업데이트가 되지 않는 문제가 발생하기 때문이다. 이러한 문제를..